La conception d’outils de veille pour le web est une tâche complexe qui se divise en trois grandes étapes avec leurs exigences spécifiques :

- Une première phase de collecte,

- L’analyse du corpus,

- La restitution sous ses multiples formes possibles.

Chacune de ces tâches représente à elle seule un ensemble de problèmes pour lesquels il n’y a pas de solutions simples. Il s’agit plutôt d’opter pour une solution particulière en fonction d’une stratégie spécifique : stratégie de collecte, stratégie d’analyse, etc.

Je parlerai aujourd’hui de la phase de collecte, qui nous tient particulièrement à cœur chez Proxem puisque nous perfectionnons jour après jour notre offre d’e-réputation et réfléchissons à ce que pourrait être la solution parfaite de veille sur le web.

Dès que l’on commence à aborder les problématiques de la collecte d’information, on est confronté à la typologie des contenus présents sur le web, qui sont non seulement très nombreux, mais hétérogènes et toujours en évolution. Très grossièrement, ces contenus se divisent :

- En documents figés, sous forme de pages web statiques qui ne changent pas ou peu et sont indexées (entièrement ou en partie) par les moteurs de recherche

- En flux de données issues de blogs, forums, réseaux sociaux, qui correspondent (grossièrement encore une fois) au web 2.0.

Certains outils de veille sur le marché font le choix de ne traiter que l’une de ces deux catégories de contenus et peuvent ainsi devenir de très bons outils de veille spécialisés. C’est d’ailleurs une stratégie souvent plus efficace qu’une tentative d’exhaustivité, celle-ci étant complètement impossible : dans les faits la majorité du web demeure inaccessible aux robots d’exploration, soit parce que l’accès aux pages nécessite une identification avec mot de passe, soit que les contenus sont structurés d’une façon que ne peuvent explorer les robots (bases de données publiques par exemples).

Sur la question spécifique des moteurs de recherche, on constate que chacun d’entre eux a une stratégie spécifique et obtient des résultats différents. Au départ, la tâche peut sembler plutôt déterministe, mais le volume de données et l’hétérogénéité de celles-ci, encore une fois, fait qu’il ne peut y avoir d’approche globale systématique et que chaque moteur de recherche a ses propres solutions locales. La conséquence de cela, c’est qu’en sortie, les résultats sont loin d’être identiques…

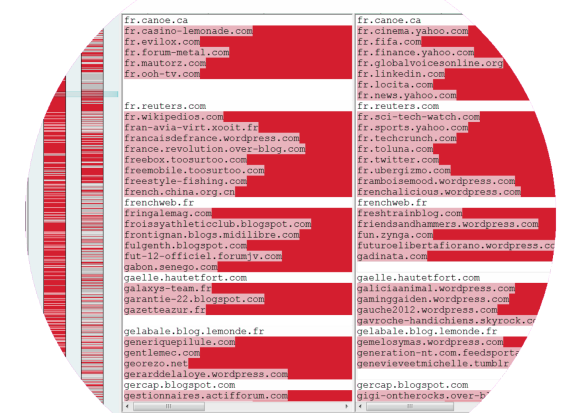

Une image valant mieux qu’un long discours, voici la comparaison de deux solutions sur une même requête à périmètre identique : les sites colorés ne sont indexés que par l’une des deux, et seuls les sites en blancs sont communs aux deux solutions.

En regardant la liste des résultats d’une requête, on voit clairement que deux outils de collectes ont un taux de recouvrement plutôt faible, et renvoient donc une image du web radicalement différente. Cela met en perspective tout ce que l’on peut dire sous la notion d’e-réputation, laquelle peut recouvrer des réalités factuelles très différentes : un début d’approche couvrante, à défaut d’être exhaustive, est de croiser plusieurs outils de collecte. De cette façon, on diminue « l’angle mort » et on se rapproche de la réalité, même si l’ensemble ne reste au final qu’un reflet imparfait de l’e-réputation d’une marque.

Ping : Pour en finir avec le mythe de la collecte “exhaustive” sur le web … « Things I grab, motley collection